这是一个创建于 546 天前的主题,其中的信息可能已经有所发展或是发生改变。

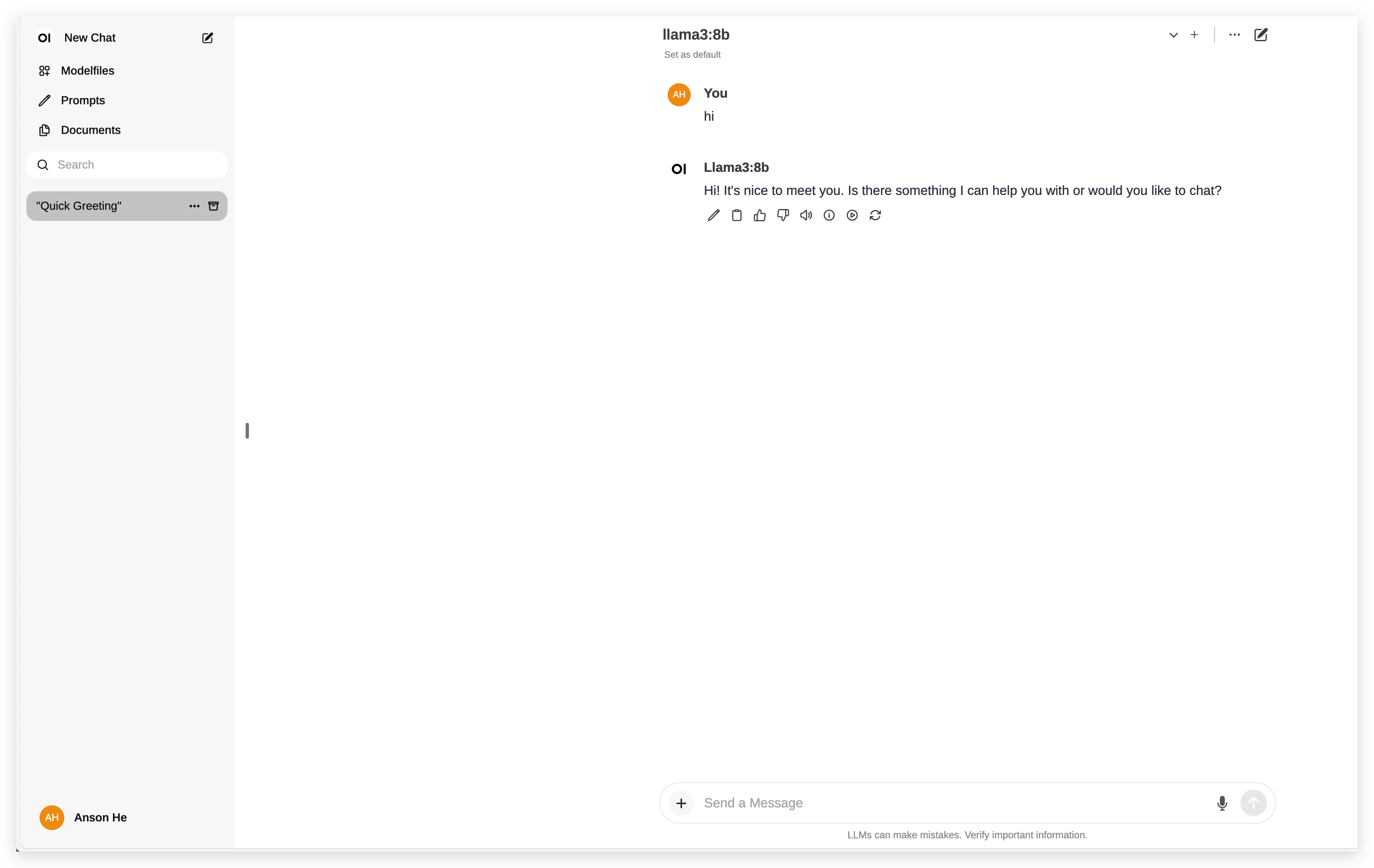

链接: https://github.com/ansonhe97/Llama3-NAS

前几天简单折腾 Llama3 跑在 NAS 上,结果确实也和预期一样,卡成...

分享下 docker 配置,也希望后续大模型会往边缘端发展,让 NAS 发光发热!

1

vicalloy 2024-05-03 16:45:26 +08:00 除非要做 RAG ,或用自己的知识库进行二次训练,不然本地跑 chatGPT 没有太大意义。

试了一下 16fp 的 7B 模型,效果不太行。 另外一定要 GPU ,CPU 慢的无法接受。 |

2

xJogger 2024-05-03 16:53:20 +08:00

3060 6G 笔记本 用 ollama 跑 Llama3 8B 的,还挺流畅

不过就试了几轮对话,没尝试太多轮 |

3

slowgen 2024-05-04 02:11:35 +08:00

CPU 跑大模型推理瓶颈就是在内存带宽,按 ddr4 双通道内存带宽为 30GB/s 的速度来算,7B 规格的 8bit 量化,也就 4 token/s 左右的速度,4bit 量化就速度 x2 ,14B 规格就速度除以 2 ,偏差不会太大。

|

4

lchynn 2024-05-04 13:07:18 +08:00

@xJogger 3060 跑 LLAMA3-8B, 平均每秒多少 token 生成速度啊?谢谢,想了解下性能? OLLAMA /SET VERBOSE 麻烦测一下看看?

|

5

xJogger 2024-05-04 13:41:51 +08:00 |