请不要把任何和邀请码有关的内容发到 NAS 节点。

邀请码相关的内容请使用 /go/in 节点。

如果没有发送到 /go/in,那么会被移动到 /go/pointless 同时账号会被降权。如果持续触发这样的移动,会导致账号被禁用。

邀请码相关的内容请使用 /go/in 节点。

如果没有发送到 /go/in,那么会被移动到 /go/pointless 同时账号会被降权。如果持续触发这样的移动,会导致账号被禁用。

这是一个创建于 297 天前的主题,其中的信息可能已经有所发展或是发生改变。

玩 pt ,经常会把旧的资源删除,给硬盘腾出空间,然后下载新的资源

开启了重复数据删除的硬盘,删除旧资源,并没有释放出很多空间出来

会导致硬盘占用越来越多

重复数据删除的原理就是把相同的数据块提取出来,多个文件共用相同的数据块,来节省硬盘空间

但删除了文件,这些被提取出来的数据块,即使没被使用,它也不懂得自动删除

导致硬盘会被这些数据块越占用越多,

重复数据删除不适合文件流转太大的硬盘

开启了重复数据删除的硬盘,删除旧资源,并没有释放出很多空间出来

会导致硬盘占用越来越多

重复数据删除的原理就是把相同的数据块提取出来,多个文件共用相同的数据块,来节省硬盘空间

但删除了文件,这些被提取出来的数据块,即使没被使用,它也不懂得自动删除

导致硬盘会被这些数据块越占用越多,

重复数据删除不适合文件流转太大的硬盘

1

myderr 2025 年 3 月 24 日

你不说我都不知道 windows server 有这个功能

|

2

littlewing 2025 年 3 月 24 日

因为重复数据块只保留一份,相当于就没多占空间啊,重复数据删除又怎么可能再多处空间来

|

3

yanqiyu 2025 年 3 月 24 日 via Android

dedup 是让不同的文件引用同一个 extent 。当然你要是删除了这些文件中某一个,只会让共享的 extent 的引用-1 ,只有引用数清零才会真正的删除并且释放空间。

但是,你就算不开 dedup ,其他文件该占的空间也是一样的占。 唯一的问题可能是这种 shared extent 导致很难算清楚“我删除这些文件之后能释放多少空间”,得扫描一下文件引用的 extent 有多少是 shared 有多少是 exclusive 。 |

4

yinmin 2025 年 3 月 24 日 via iPhone

删除重复数据功能里可以设置“排除目录”的,你把资源库目录排除即可。

关于空间没有释放的问题,可能要等下次运行“数据删除重复服务”之后才恢复吧,你可以看一下“设置删除重复计划(S)…”里配置的计划安排。 |

5

PrinceofInj 2025 年 3 月 24 日

重复数据删除默认好像是五天后才会检查吧,不是实时的

|

6

clorischan 2025 年 3 月 24 日

用最新版本 ReFS 文件系统自带的重复数据删除, 就是删除文件后立即释放的.

前几天刚把 NAS 系统升级到 Windows Server 2025. 然后把原来用的就是旧的重复文件删除, 顺便切换到新的 ReFS 内置的去重, 就可以做到删除立即释放 而且最新的 ReFS 默认已经开启块克隆 (CoW), 在同分区内复制粘贴文件瞬间完全, 也不占用额外空间 |

7

HughRyu 2025 年 3 月 25 日

技术原理与优化

在 Windows Server 中,数据去重技术的工作原理是通过识别和删除存储中的冗余部分,只保留数据的唯一副本。这项功能的主要特点包括: 基于块的重复数据删除:通过按块对数据进行分解,然后对比不同文件或数据块的内容,找出相同的部分,删除冗余数据,只保留一个唯一的块,并通过引用方式来节省空间。 实时去重:数据被写入存储介质时,系统实时对数据进行重复数据删除处理。 可配置的去重范围:管理员可以配置去重策略,选择需要启用去重的文件夹、卷、备份目标等。 这些优化使得存储空间的使用效率大幅提升,并减少了硬件成本。 去重是底层逻辑,和你应用层面有啥关系? |

8

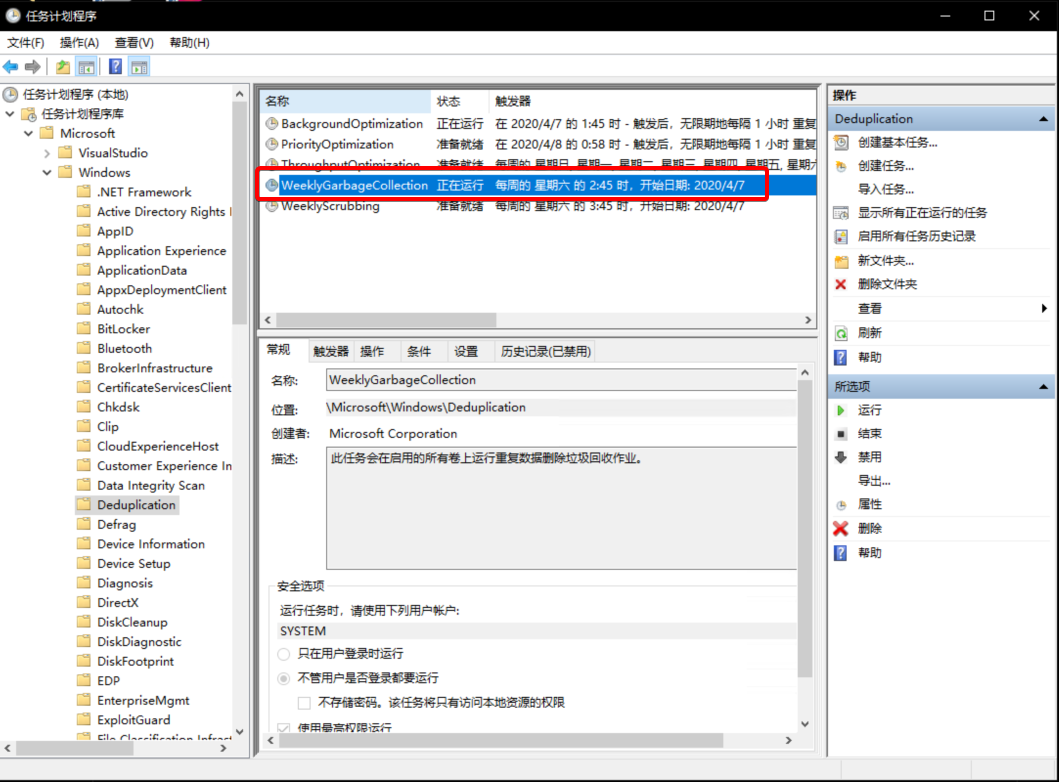

copyliu 2025 年 4 月 10 日

你既然是下载用的文件夹就 **不存在重复数据**

Windows Server 的重复数据删除在删除文件之后是需要做垃圾回收才能释放空间的 具体在  你可以等他自动运行, 或者手动运行. |